반응형

Image Classification

LeNet

- CNN의 개념을 최초로 고안한 Yann Lecun이 개발

- LeNet-5 (Layer가 5개)

- input 32 * 32 * 1 - 채널이 1개

- Gaussian connection : F6의 각 neuron의 출력은 output layer로 전달되기 전에 Gaussian kernel에 의해 변환됨

→ 원래는 사이에 구분하기 위한 선을 그어야 한다. 하지만 선을 하나만 그어서 구분이 안 가서 선을 여러 개 긋는다.

→ 그래서 SVM에서는 데이터가 섞여있는 패턴을 봄 (?)

transform 하는 패턴 중 하나가 Gaussain kernel이다.

- LeNet에서는 aveage pooling을 사용한다.

- C1에서 5*5 convolution 연산할 때 채널이 16개이면 조합해서 비대칭으로 연결해서 global feature가 만들어지길 기대한다.

- C5에서 120개 feature를 생성

feature maps

GAP (Global Average Pooling)

- conv layer에서 만든 feature map의 전체를 가지고 pooling을 한다.

- conv layer의 high dimensionality → need reduction on the dimension

- max ppooling을 하면 size를 모두 1/2로 줄임

- glover average pooling

- final layer with GAP

CAM (Class Activation Mapping)

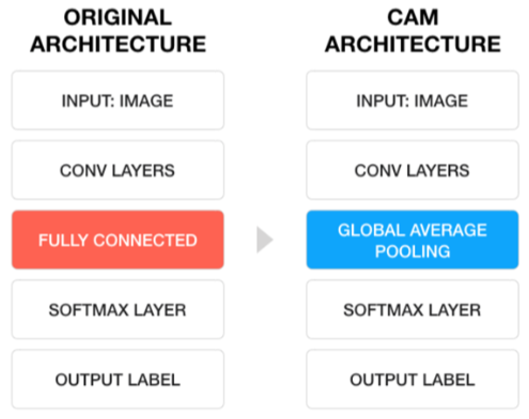

Original CNN vs CAM

- input은 똑같다. CAM은 global average pooling을 거친다.

- softmax layer를 거쳐서 output

- CNN은 convolution layer에서 feature map을 1차원으로 펴서 Fully Connected Layer의 Flatten 과정에서 데이터가 손실된다.

- CAM은 GAP을 통해서 하게 되면 데이터가 조금 살아있다 (?)

반응형

'AI > 이미지인식' 카테고리의 다른 글

| [AI] CNN(Convolutional Neural Network)이란? - 개념 및 실습 (0) | 2020.12.15 |

|---|